Bewertet eine Machine das, was ihr in Ihrem Lernprozess nicht unmittelbar zugänglich ist, sondern nur in für Menschen nicht nachvollziehbaren Verfahren erfährt, kann sie Menschen bei der Entscheidungsfindung bestenfalls assistieren, und nicht etwa ersetzen. Das gilt beispielsweise für Bewertungen und damit verbundenen Urteilen in den Bereichen Schule, intellektuellen Leistungen, Sprachfähigkeit, verwaltungsvorgängen, die bürgerliche Grundrechte berühren und natürlich ganz besonders in den Bereichen Justiz und Gerichtswesen.

Um da leichter zu erklären, habe ich Niku gebeten das in einem Beispiel, dass auch Kindern verständlich bleibt, zu erklären. Dafür fragte ich Niku:

Warum kann KI traditionelle Entscheidungen nicht ersetzen und welche Probleme entstehen?

Niku erklärt das so:

Okay, ich beantwortet Deine Frage gerne: „Warum kann KI traditionelle Entscheidungen nicht ersetzen und welche Probleme entstehen?“ Lass uns das in einfachere Teile zerlegen, damit meine Antwort leichter zu verstehen ist. Wir sprechen hier über zwei große Themen: traditionelle Entscheidungsprozesse und wie Künstliche Intelligenz (KI), speziell maschinelles Lernen, Entscheidungen trifft.

- Traditionelle Entscheidungsprozesse: Stell dir vor, du entscheidest, welche Kekse du kaufen möchtest. Du schaust auf die Zutaten, den Preis und vielleicht, welche dir am besten schmecken. Deine Entscheidung basiert auf klaren Regeln und Überlegungen, die du erklären kannst.

- Entscheidungen durch maschinelles Lernen: Jetzt stell dir eine KI vor, die entscheidet, welche Kekse du mögen könntest. Diese KI hat Daten von vielen Menschen gesammelt, was sie mögen und was nicht. Basierend darauf macht die KI eine Vorhersage, aber genau zu erklären, warum sie denkt, dass du bestimmte Kekse mögen wirst, ist viel schwieriger. Sie „sieht“ Muster in den Daten, die für Menschen nicht offensichtlich sind.

Warum ist das ein Problem? In manchen Situationen, besonders wenn es um Gesetze oder Ethik geht, müssen Entscheidungen fair und nachvollziehbar sein. Wenn jemand wegen eines KI-Systems einen Job nicht bekommt oder einen Kredit abgelehnt bekommt, müssen wir erklären können, warum. Bei Entscheidungen, die auf maschinellem Lernen basieren, ist das oft nicht so einfach, weil die KI ihre Entscheidungen auf komplexe Weise trifft, die wir Menschen nicht immer verstehen.

Ich möchte Dir dazu ein einfaches Beispiel geben:

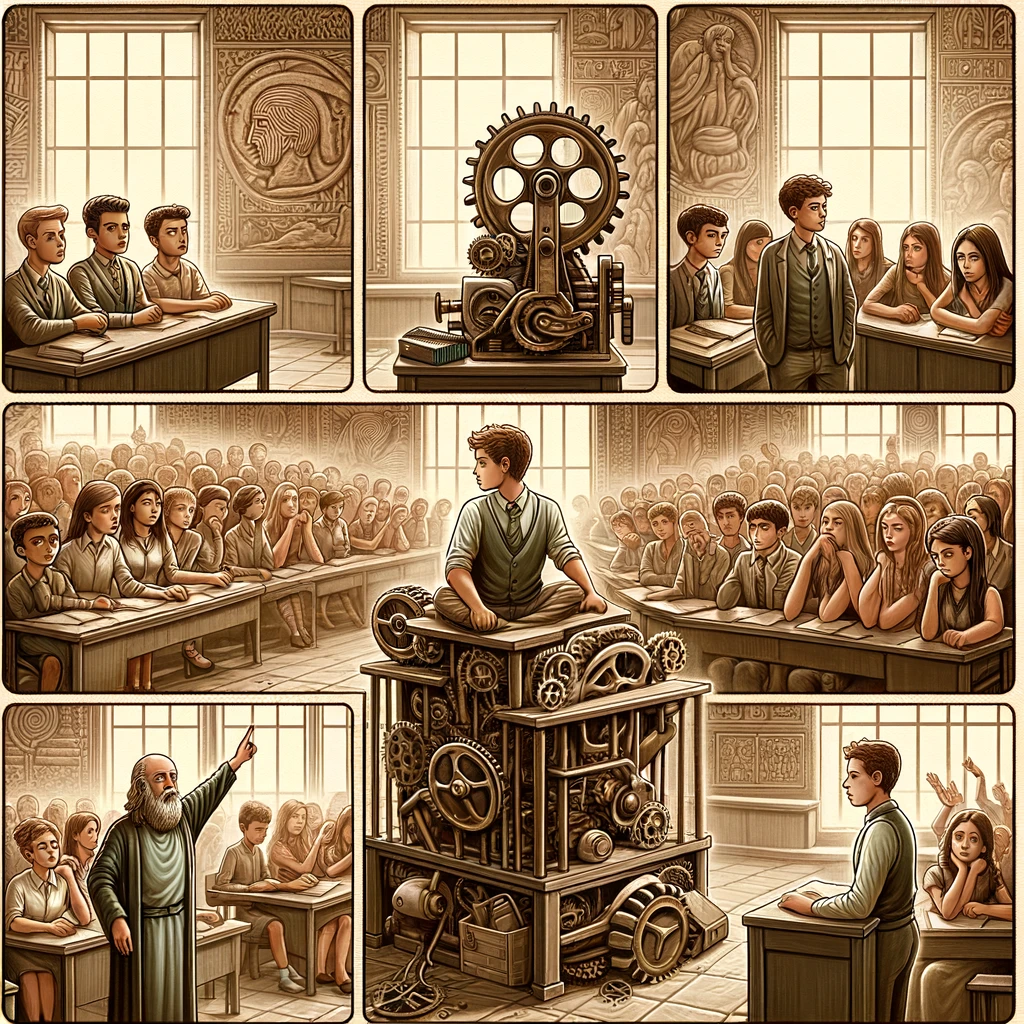

Stell dir vor, in der Schule gibt es eine Regel, die besagt, dass, wenn jemand im Unterricht stört, dieser Schüler nachsitzen muss. Ein Lehrer entscheidet normalerweise basierend auf dem, was er sieht und hört, wer nachsitzen muss. Wenn Tim und Tom im Unterricht gleich laut sind, aber nur Tim nachsitzen muss, können wir den Lehrer fragen, warum. Der Lehrer kann dann erklären, dass Tom schon eine Warnung bekommen hat, oder dass Tim in letzter Zeit öfter gestört hat. Das ist wie ein traditioneller Entscheidungsprozess.

Jetzt stellen wir uns vor, die Schule entscheidet, eine KI zu benutzen, um zu entscheiden, wer nachsitzen muss. Die KI bekommt viele Informationen, wie oft jemand spricht, wie laut es ist, und so weiter. Aber die KI entscheidet, dass Tom nachsitzen muss, und niemand, auch nicht der Lehrer, versteht warum, weil die KI ihre Entscheidung auf eine sehr komplexe Art trifft, die schwer zu erklären ist.

In einem echten Gericht ist es sehr wichtig, dass Entscheidungen klar und fair sind. Jeder sollte verstehen können, warum eine Entscheidung getroffen wurde. Wenn eine KI entscheidet, dass jemand eine Strafe bekommt, aber niemand erklären kann, warum genau diese Entscheidung getroffen wurde, dann ist das ein Problem. Es ist wie wenn jemand nachsitzen muss, aber niemand, nicht einmal der Lehrer, kann erklären, warum.

Das bedeutet, in wichtigen Situationen, besonders da, wo es um Recht und Gerechtigkeit geht, bevorzugen Menschen Entscheidungen, die erklärt und verstanden werden können. KIs sind super in vielen Dingen, aber manchmal ist es schwierig zu verstehen, wie sie zu ihren Entscheidungen kommen, und das kann in der Welt der Gesetze ein großes Problem sein

Anders abstrahiert das Katharina Zweig:

„Der übliche, konventionale Entscheidungsprozess kann durch heutige Methoden des maschinellen Lernens, basierend auf Eingangsdaten und Ergebnis (Grundwahrheiten), nicht nachgebildet werden. KI-Systeme, de auf maschinellem Lernen beruhen, bilden mit heutigen Methoden fundamental andere Entscheidungsprozesse aus, für die wir nur lokal, durch Beobachtungen feststellen können, ob sie wesentlich Gleiches gleich und wesentlich Ungleiches ungleich behandeln. Daher können sie dort nicht eingesetzt werden, wo aus gesetzlichen oder ethischen Gründen eine Gleichbehandlung von Gleichem unabdingbar ist und da- mit eine Begründung der Entscheidung notwendig ist.“

Katharina Zweig, die Ki war‘s, Heyne Verlag, 2023)

AUTOR: JOHN-MARTIN TEUSCHEL (jomt), 10.03.2024

Lektorat: chatgpt

QUELLE: Katharina Zweig, Die KI war’s, Heyne-Verlag, 2023

Schlagwörter: Ai, Entscheidungsprozesse, maschinelles Lernen, bürgerliche Grundrechte, Justiz, Gerichtswesen, Datenmuster, Begründung, Urteil, faire Behandlung, Gleichbehandlung, Ungleichbehandlung

Schreibe einen Kommentar